À propos de l’auteur

Walter Bohatsch est un designer graphique et typographe autrichien, membre de l’AGI. Il a été un temps enseignant en design et en typographie et est le fondateur du studio de design graphique Bohatsch und Partner. Il a gagné plusieurs prix, dont « Le plus beau livre d’Autriche » en 1990, 2004 et 2007.

Un ouvrage de présentation d’un système typographique

Quand on tape « Walter Bohatsch » sur Google images, on tombe rapidement sur le projet qui est sans doute le plus célèbre de cet auteur : les Typojis, et notamment l’édition qui est associée.

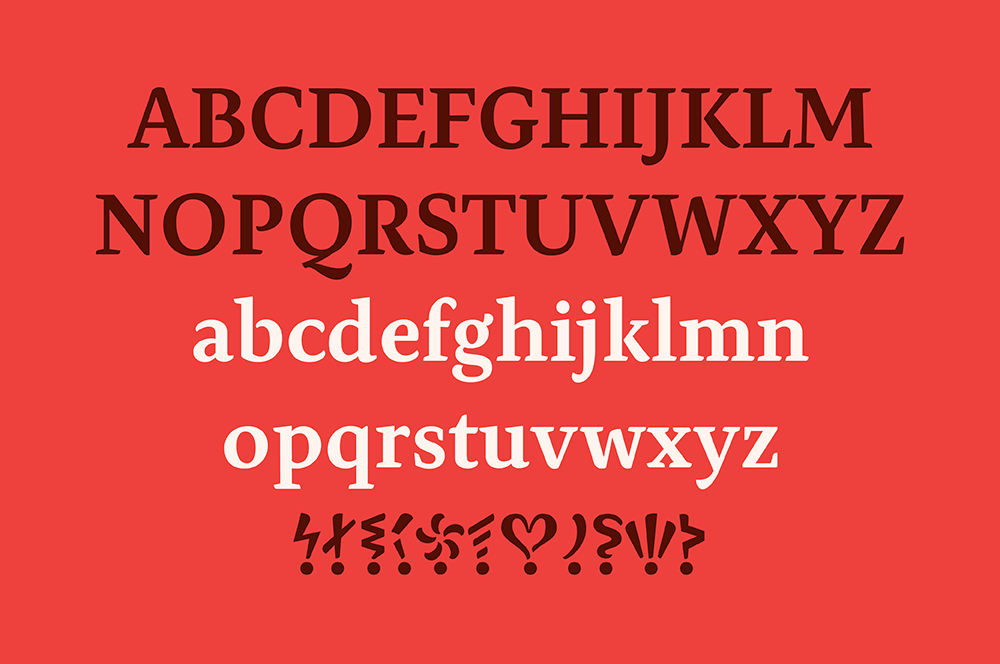

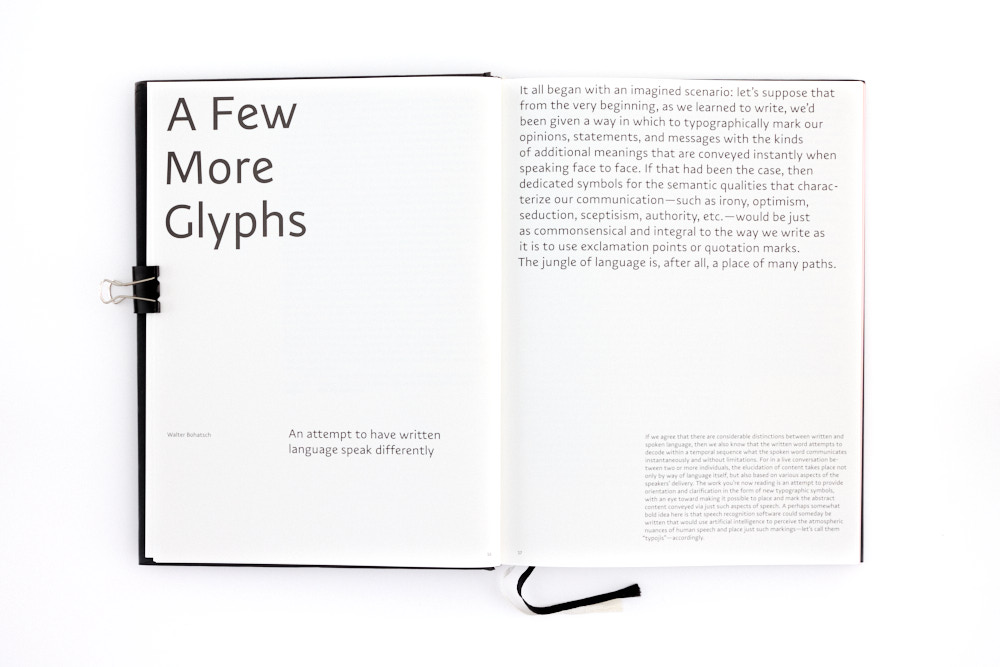

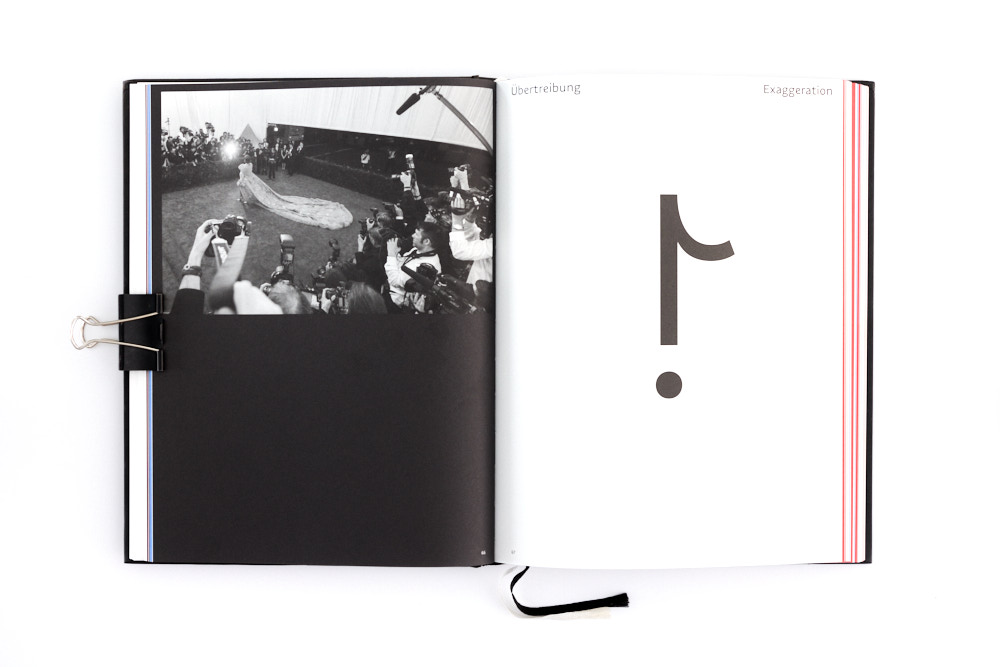

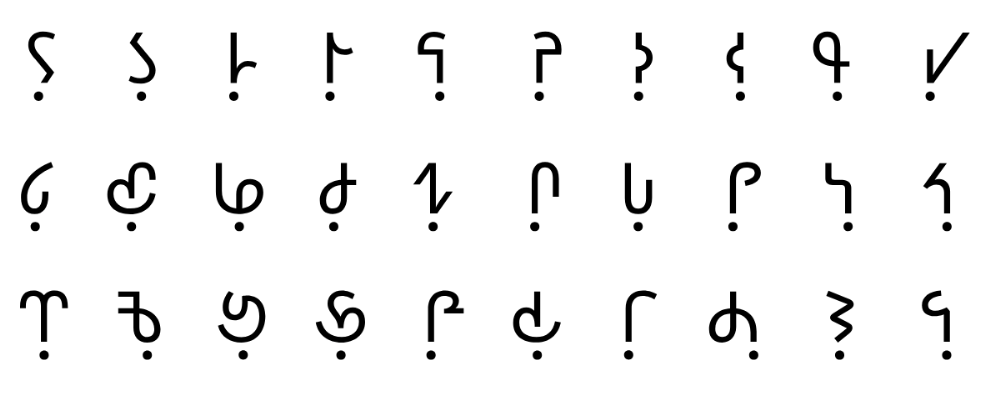

Cet ouvrage, d’un format assez généreux de 187 × 250 cm pour 240 pages, est à la fois un spécimen, une présentation et un cahier d’apprentissage d’un caractère typographique comprenant 30 nouveaux signes de ponctuation signifiant les émotions et nommé Typojis. L’ouvrage est entièrement bilingue allemand-anglais et se segmente en plusieurs blocs. Le premier étant dédié à une présentation générale du système, suivi par une série de textes par des auteurs invités. L’essentiel du livre est occupé par un bloc de présentation des 30 signes, toujours présentés de la même manière : une photographie issue de la culture mondiale (politique, culture, etc.), le signe en pleine page, une double page de phrases d’exemple sur fond bleu en page de gauche, et en rouge en page de droite. Vient ensuite une double page en forme de cahier d’exercice de traçage du signe à la manière d’un cahier d’écolier, on peut ainsi s’entrainer au traçage de ces nouveaux glyphes. On finit par un spécimen complet du caractère typographique Typojis sur une page, montrant à la fois les 30 signes et les caractères usuels. À noter que l’ensemble de l’ouvrage est composé avec le-dit caractère, qui en soit suffit en tant que spécimen des caractères alphabétiques qui sont autrement moins mis en avant par rapport aux 30 signes pour les émotions.

À propos des typojis

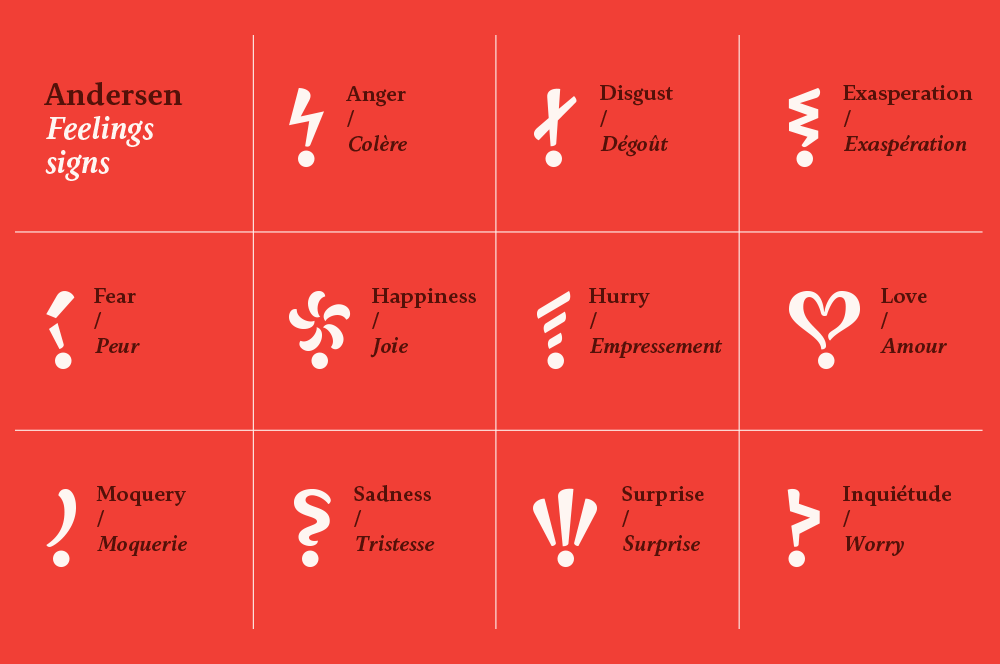

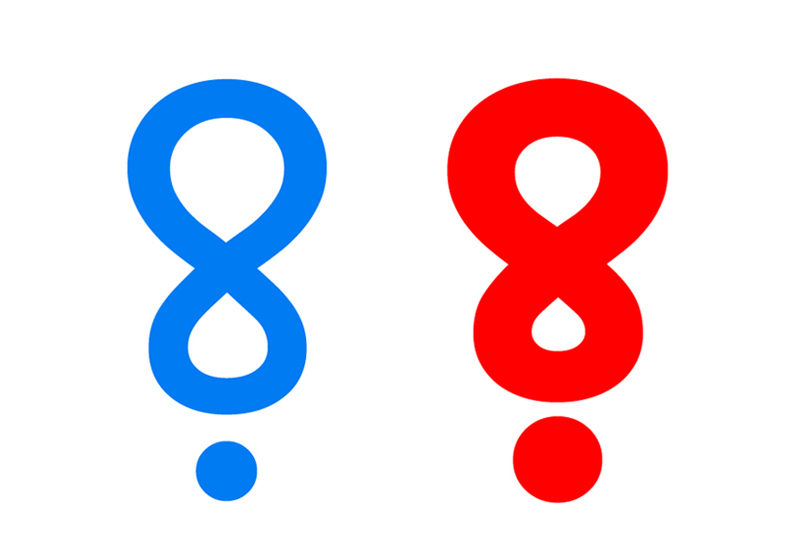

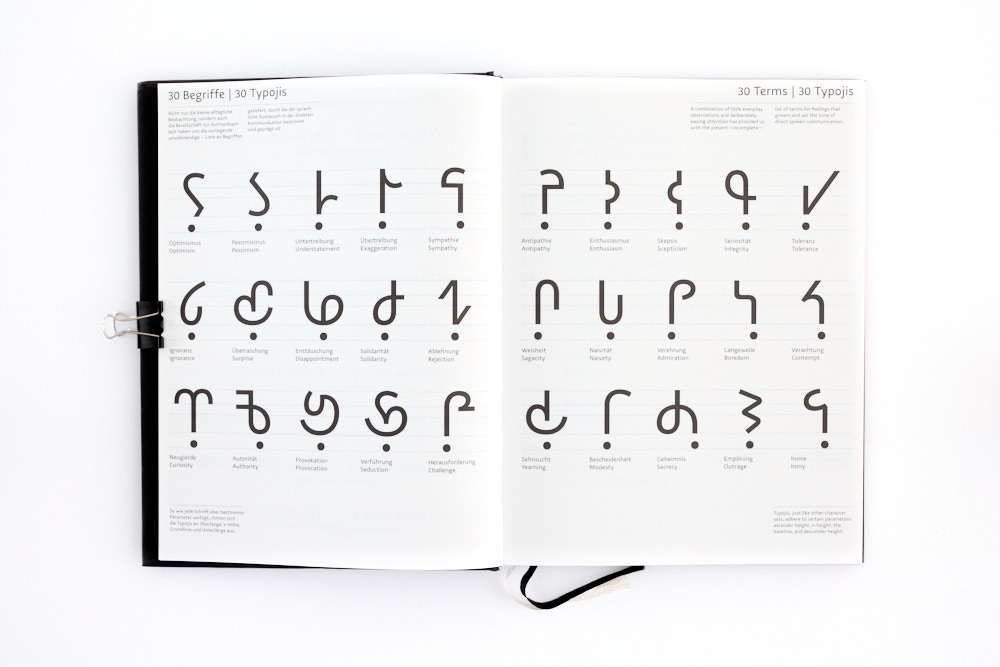

Les typojis (on fera ici usage de ce terme pour désigner les signes spécifiques du caractère) codent 30 sentiments et tons : Optimisme, Pessimisme, Euphémisme, Exagération, Sympathie, Antipathie, Enthousiasme, Scepticisme, Intégrité, Tolérance, Ignorance, Surprise, Déception, Solidarité, Rejet, Sagacité, Naïveté, Admiration, Ennui, Mépris, Curiosité, Autorité, Provocation, Séduction, Challenge, Aspiration, Modestie, Secret, Outrage, et Ironie. Leur construction est basée sur la construction des signes d’exclamation et d’interrogation, avec un point en bas et une forme plus ou moins courbe en chef.

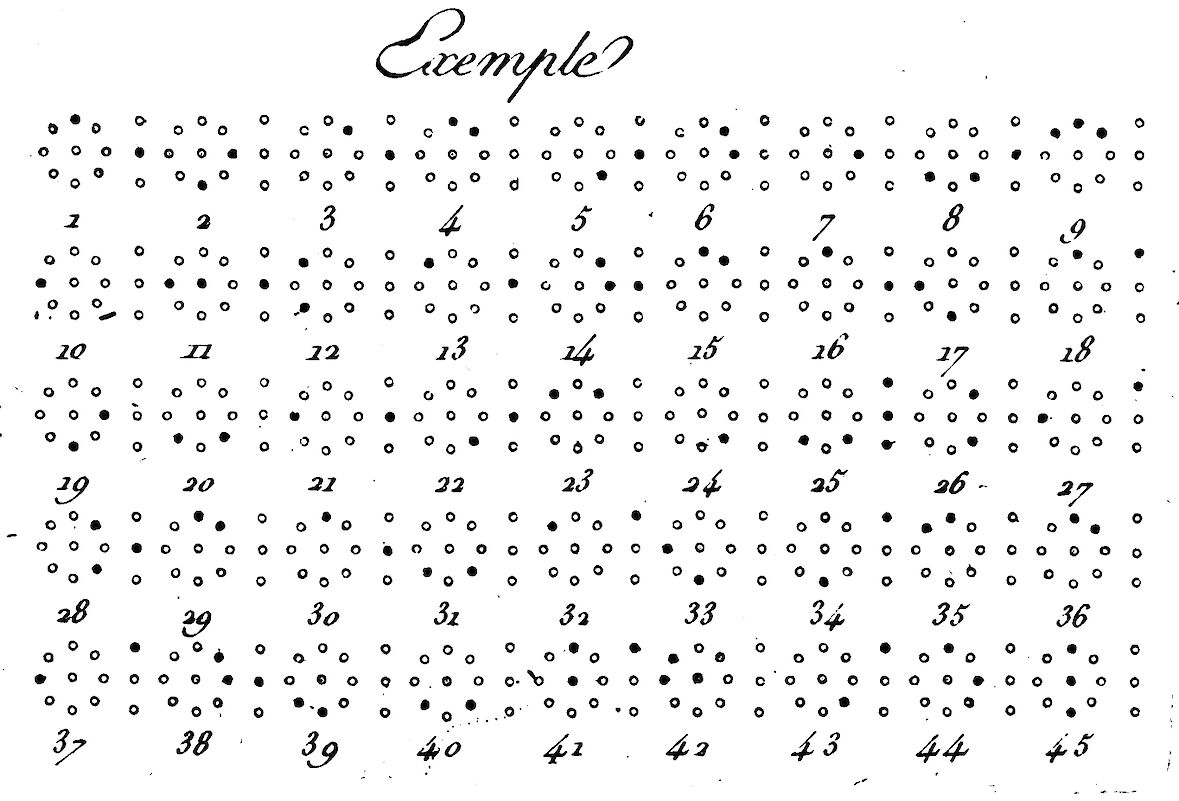

Certain signes codant pour des émotions opposées sont dessinés en symétrie, verticale par exemple pour l’Enthousiasme et le Scepticisme ou horizontale pour le cas de l’Euphémisme et de l’Exagération. Dans cette symétrie le point souscrit n’est jamais impacté, seul la partie supérieure l’est. Aucun de ces signes ne semblent pas s’inspirer de formes existantes de signes de ponctuation pour les émotions ou de formes graphiques connues. C’est particulièrement prégnant pour le signe pour la séduction, qui aurait pu évoquer une sorte de cœur, ce qui aurait indiqué la thématique générale invoquée.

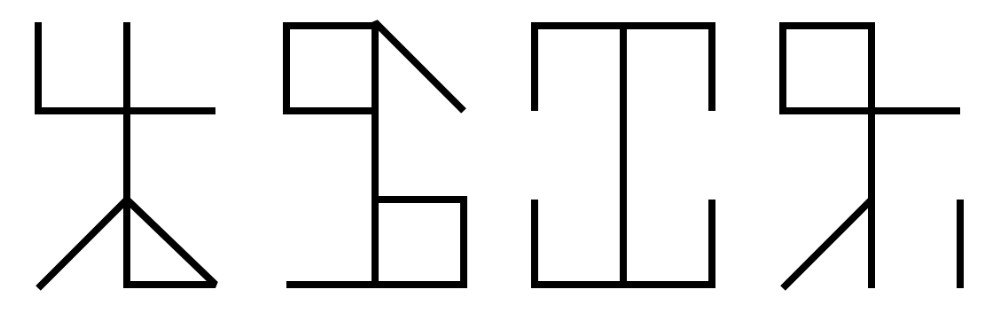

Si certains signes sont faciles à écrire, d’autres le sont beaucoup moins, le signe pour la Provocation et la Séduction étant selon moi les plus difficile à prendre en main. Je sais que la pratique de l’écriture manuscrite s’amenuise, mais je me serai attendu à des formes avec un tracé relativement simple. On est bien là sur de la typographie, dans son sens mécanique, et pas dans la calligraphie, dans son sens manuel. D’ailleurs le caractère Andersen, dont j’ai parlé dans le billet précédent, et qui a une thématique similaire, n’est lui aussi pas adapté selon moi à un traçage manuel de ses signes. Dans les deux cas, on est là dans une proposition graphique pensée pour la composition de texte et sa lecture, pas pour son traçage.

Pour ce qui est de l’utilisation de ces 30 signes, c’est un simple système OpenType de ligature qui permet de les ajouter à un texte. Il suffit d’entourer le nom (anglais) du signe par les signes d’addition pour faire remplacer la formule par le signe correspondant. Par exemple pour l’Optimisme, on notera « +optimism+ ». Simple et efficace.

À propos du nom

Le terme « typoji » contraction assez claire de « typographie » et d’« emoji » évoque donc un système graphique bien connu de représentation d’émotions (bien que maintenant les emojis soient bien plus variés) sous forme de petites images. C’est là donc que je trouve que le nom donné, bien que je le comprenne, ne me semble pas le plus adapté. En effet l’intérêt des emojis réside dans leur forme illustrative, permettant, en théorie, une compréhension immédiate, ne nécessitant pas d’apprentissage particulier (c’est évidemment bien plus compliqué que cela) et donc adaptée à leur usage dans les conversations à l’heure d’internet et des réseaux sociaux. Ce sont des icônes. Selon moi, les typojis sont eux des signes à plus rapprocher du système de ponctuation, nécessitant donc un apprentissage de leur signification. Ce sont donc des symboles.

Disant cela, je ne résous pas le problème et il est clair que d’avoir choisi typoji connecte ce travail à une certaine contemporanéité en proposant des signes plus ‘typographiques’ et possiblement moins perturbant que les emojis, qui sommes toute ne sont quasiment pas utilisés dans la composition de textes littéraires par exemple, probablement car considérés comme trop familiers. Ce terme permet également d’inférer l’utilité et le domaine d’intervention de ce système. En cela le mot-valise typoji est tout à fait adapté. À vous maintenant de vous faire votre avis.